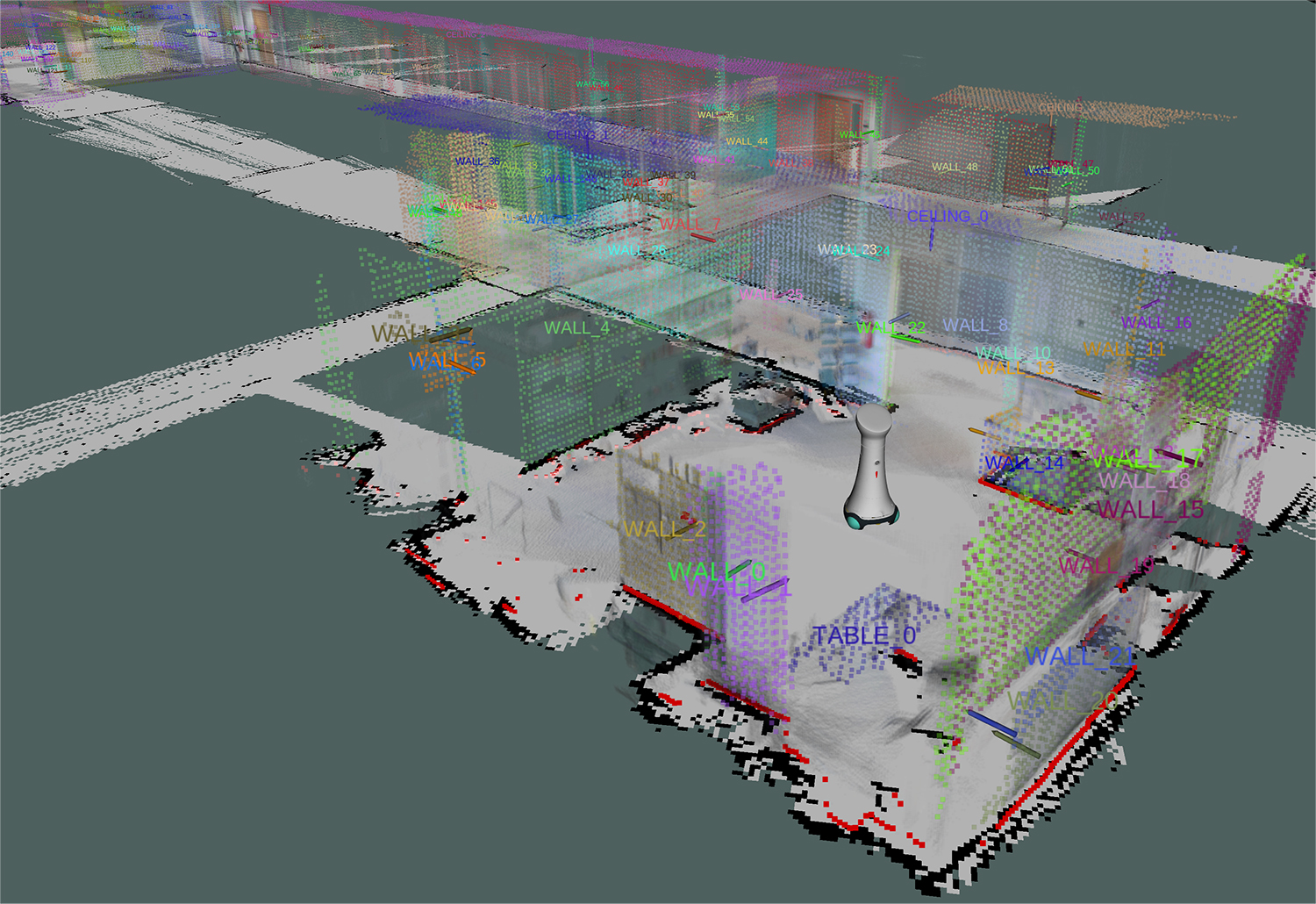

Menschen interpretieren eine Szene anhand von zahlreichen Informationen wie Sprache, Geräuschen, Texten, räumlichen und visuellen Eindrücken und erfassen damit intuitiv, was das Gegenüber tut oder plant. »Unser Beitrag, damit ein Roboter dieses Verständnis erhält, war die Erweiterung unseres Umgebungsmodells um Semantiken. Diese Semantiken ergänzen die Bedeutung der Umgebungsinformation, die zunächst nur als dreidimensionale Punktwolke vorliegt. Die Semantiken identifizieren einzelne Objekte wie beispielsweise Stühle, Tische oder Pflanzen und liefern so mögliche Aufmerksamkeitsziele«, erklärt Florenz Graf, der im Projekt die Arbeiten des Fraunhofer IPA koordinierte. Softwaremodule für die Erkennung und Klassifizierung geometrischer Formen und für die Ableitung entsprechender Raumstrukturen ermöglichen dieses Verständnis.

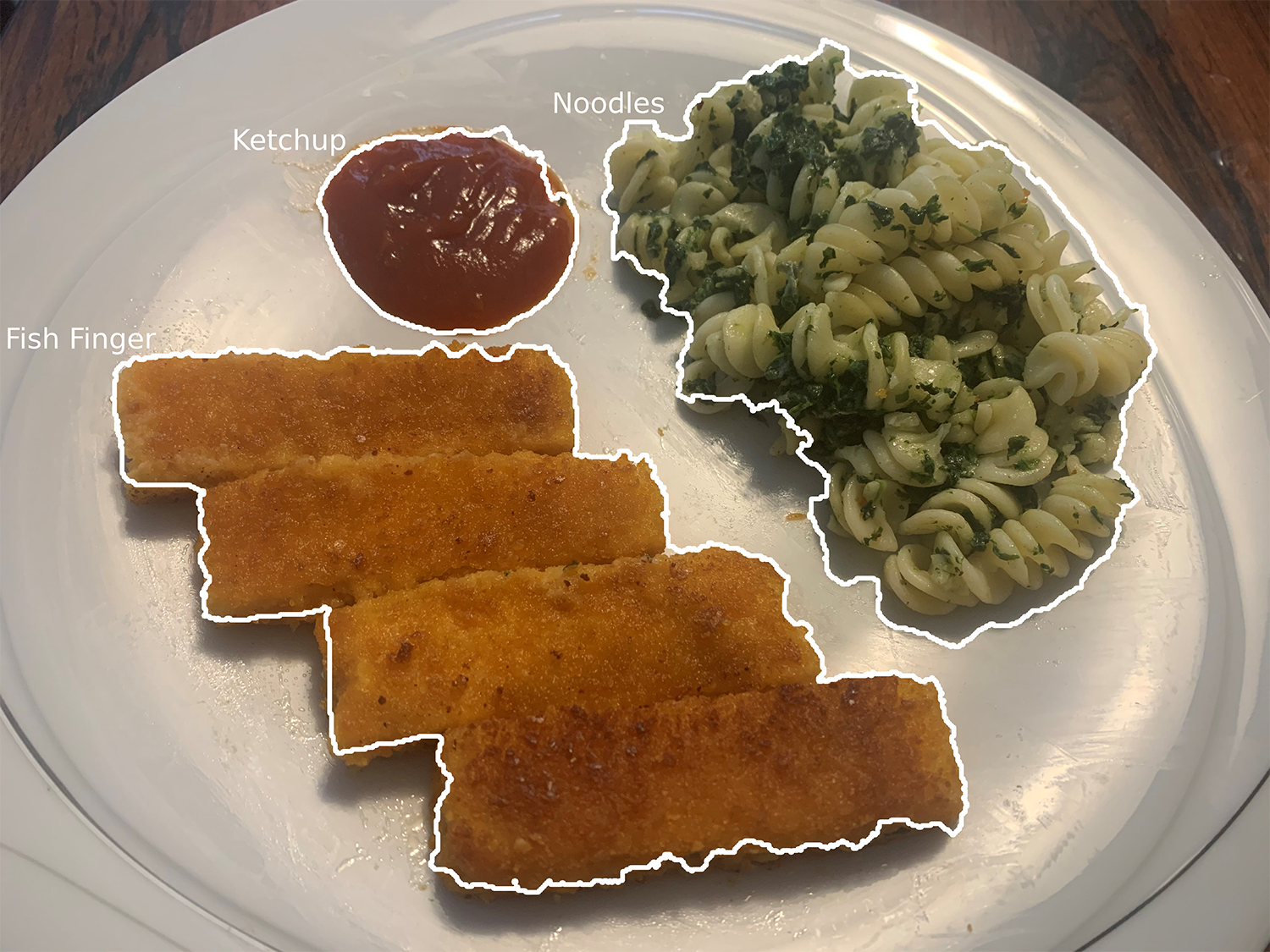

»Die genannten Technologien ergänzen unsere bereits vorhandenen Algorithmen zur Personen- und Aktivitätenerkennung bestens. Gemeinsam ermöglichen sie einem Roboter, eine Szene ganzheitlich zu verstehen«, so Graf. Praktisch getestet wurden die Technologien in einem Anwendungsszenario, in dem Care-O-bot® 4 eine Person durch ein Gebäude sicher und aufmerksam zu ihrem gewünschten Ziel begleitet.